De EU zet een stap in AI-governance met de Artificial Intelligence Act (AI Act)

De Europese Unie heeft een belangrijke stap gezet in het beheer van kunstmatige intelligentie (AI) met de Artificial Intelligence Act (AI Act) — de eerste AI-wetgeving ter wereld. Deze wet creëert een gestructureerd kader om AI-technologieën op een ethische en innovatieve manier te reguleren.

Low-code ontwikkelplatforms, waarmee applicaties kunnen worden gemaakt met minimale handmatige codering, integreren steeds vaker AI-componenten om nieuwe functionaliteiten te bieden. Gezien de bepalingen van de AI Act is het van cruciaal belang dat ontwikkelaars die low-code platforms gebruiken de risiconiveaus van hun AI-integraties beoordelen om naleving en verantwoord gebruik te waarborgen.

Dit artikel geeft een overzicht van de belangrijkste aspecten van de AI Act, het risicoclassificatiesysteem, de implementatietijdlijn, de wereldwijde impact, en de vereisten voor Europese bedrijven.

Doelstellingen van het EU AI Act-raamwerk

Belangrijkste inzichten

- Bedrijven zijn verantwoordelijk voor zowel intern ontwikkelde AI als voor AI van derden die geïntegreerd is in aangekochte software.

- AI wordt steeds breder toegepast binnen organisaties — soms doelgericht ontwikkeld, soms onzichtbaar geïntegreerd in softwaretools.

- Niet-naleving kan leiden tot hoge boetes tot €35 miljoen of 7% van de wereldwijde jaaromzet.

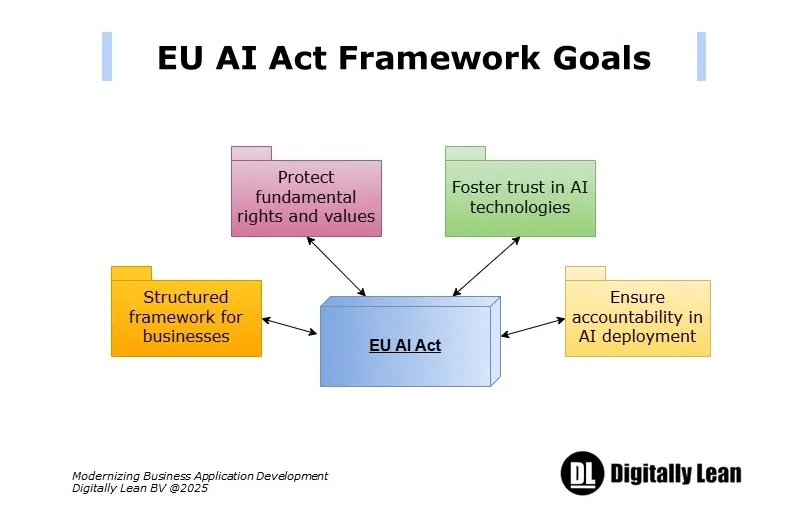

EU AI Act — Doelstellingen

De AI Act volgt een risicogebaseerde reguleringsaanpak om te garanderen dat systemen veilig, transparant en in lijn met fundamentele rechten zijn. AI-toepassingen worden ingedeeld op basis van hun potentiële risico’s. De regelgeving heeft als doel:

- Vertrouwen in AI-technologieën te bevorderen.

- Fundamentele rechten en maatschappelijke waarden te beschermen.

- Een gestructureerd nalevingskader voor bedrijven te bieden.

- Verantwoording in AI-implementatie te waarborgen.

EU AI Act — Tijdlijn

De AI Act is in werking getreden op 1 augustus 2024, met een gefaseerde implementatie:

- Februari 2025: Verplichting tot AI-geletterdheidstrainingen en het verbod op AI-systemen met onaanvaardbaar risico.

- Augustus 2025: Verplichtingen voor aanbieders van general-purpose AI (GPAI), benoeming van nationale toezichthoudende autoriteiten en jaarlijkse herziening door de Europese Commissie van verboden AI.

- Augustus 2026: Uitbreiding van nalevingsverplichtingen naar hoog-risico AI-systemen, invoering van sancties en opzet van AI-sandboxen door lidstaten.

- Augustus 2030: Inwerkingtreding van sectorspecifieke AI-regels, inclusief naleving voor grote IT-systemen.

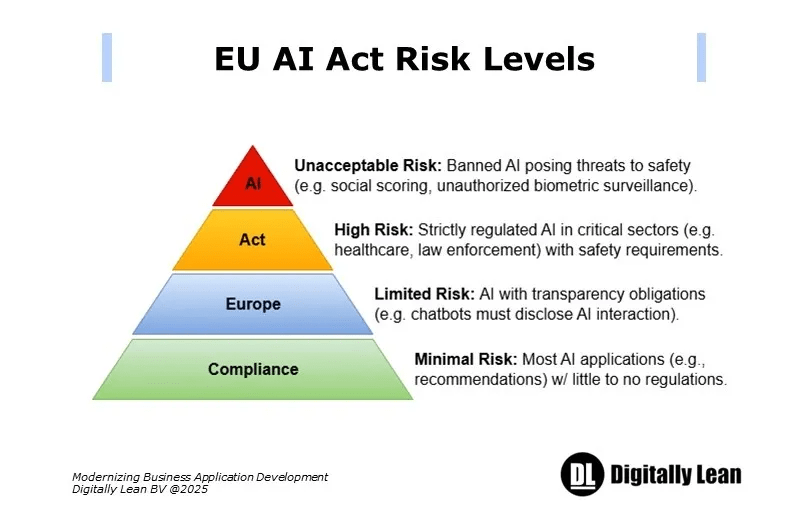

EU AI Act — Risicoclassificatie

De risicogebaseerde classificatie van AI-systemen binnen de AI Act kent vier niveaus:

- Onaanvaardbaar risico: Verboden AI-systemen die een ernstige bedreiging vormen voor veiligheid of fundamentele rechten, zoals sociale scoring door overheden of realtime biometrische identificatie in openbare ruimtes zonder wettelijke grondslag.

- Hoog risico: AI in kritieke sectoren zoals werkgelegenheid, rechtshandhaving en gezondheidszorg. Vereist naleving van transparantie-, eerlijkheids- en veiligheidsnormen, inclusief risicoanalyses, databeheer en conformiteitsbeoordelingen.

- Beperkt risico: AI met beperkte risico’s, onderworpen aan transparantieverplichtingen, zoals het informeren van gebruikers dat ze met AI communiceren (bijv. chatbots).

- Minimaal risico: Het merendeel van de AI-toepassingen, zoals aanbevelingsalgoritmen, valt onder minimale of geen regulatoire eisen.

EU AI Act — Buiten de EU

De AI Act geldt niet alleen voor bedrijven binnen de EU, maar ook voor internationale ondernemingen die AI-systemen inzetten binnen de EU-markt. Organisaties moeten hun AI-governance afstemmen op de vereisten van de Act om sancties te vermijden.

Deze brede reikwijdte zal naar verwachting leiden tot een wereldwijde standaard voor verantwoord AI-gebruik.

EU AI Act — Naleving

Organisaties die AI ontwikkelen of gebruiken binnen de EU, moeten zorgen voor operationele naleving en passende aanpassingen doen, waaronder:

- Het uitvoeren van risicobeoordelingen voor AI-toepassingen.

- Transparantie in AI-besluitvormingsprocessen.

- Beoordeling van fundamentele rechten bij hoog-risico AI-systemen.

- Grondige documentatie en monitoring om aan regelgeving te voldoen.

- Registratie van hoog-risico AI in de nieuw opgerichte EU AI-database.

EU AI Act — Innovatie

Om de regeldruk voor kleine en middelgrote ondernemingen (kmo’s) te beperken, introduceert de AI Act:

- Regulatory sandboxes om innovatie mogelijk te maken onder toezicht.

- Proportionele maatregelen om overregulering van kmo’s te voorkomen.

Bedrijven die AI willen implementeren in overeenstemming met de AI Act, kunnen gebruikmaken van hulpmiddelen die naleving vereenvoudigen.

Een voorbeeld is het OutSystems Platform AI Workbench, dat een intuïtieve interface, vooraf ingestelde sjablonen en integratieklare componenten biedt. Hiermee kunnen organisaties:

- De doorlooptijd verkorten via vooraf gebouwde AI-modellen en databronnen.

- Naleving garanderen dankzij ingebouwde beveiliging en privacycontroles.

- De AI-governance verbeteren binnen een gestructureerd kader.

Voor meer informatie over de Low Code AI zie ons contact referentie sectie.

Conclusie

De EU AI Act zet een wereldwijde standaard voor AI-regelgeving en vindt een balans tussen innovatie en ethisch toezicht.

Door de nadruk te leggen op ethisch bestuur, transparantie en verantwoordelijkheid, kan deze wet een inspiratiebron zijn voor andere regio’s.

Voor low-code platforms die AI integreren, is een grondig begrip van de AI Act cruciaal. Ontwikkelaars moeten zorgen voor transparantie, bias-mitigatie, en menselijke controle, vooral bij hoog-risico toepassingen.

Bedrijven doen er goed aan zich proactief voor te bereiden op naleving, zodat hun AI-systemen voldoen aan de eisen van transparantie, veiligheid en verantwoordelijkheid.

(This article is also in English here)